Explorer

jeSi quelqu’un vous dit un fait que vous connaissez déjà, il ne vous a pratiquement rien dit du tout. Alors que s’ils confient un secret, il est juste de dire que quelque chose a vraiment été communiqué.

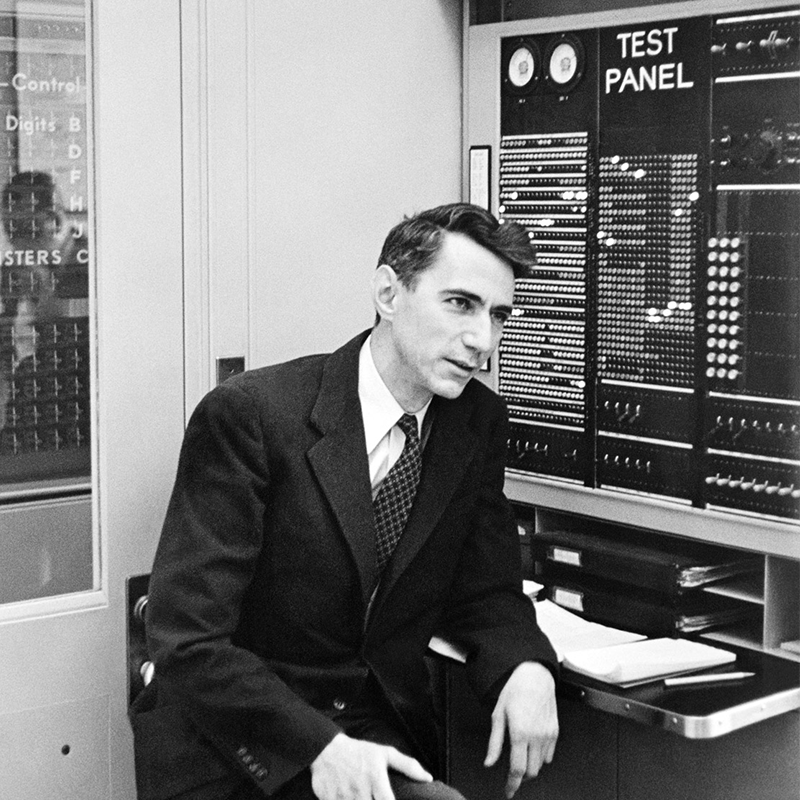

Cette distinction est au cœur de la théorie de l’information de Claude Shannon. Introduit dans un article d’époque de 1948, “A Mathematical Theory of Communication”, il fournit un cadre mathématique rigoureux pour quantifier la quantité d’informations nécessaires pour envoyer et recevoir avec précision un message, tel que déterminé par le degré d’incertitude autour de ce que le message prévu pourrait être. en disant.

C’est-à-dire qu’il est temps de donner un exemple.

Dans un scénario, j’ai une pièce astucieuse, c’est face des deux côtés. Je vais le retourner deux fois. Combien d’informations faut-il pour communiquer le résultat ? Aucun, car avant de recevoir le message, vous avez la certitude que les deux flips tomberont face.

Dans le deuxième scénario, je fais mes deux lancers avec une pièce normale : pile d’un côté, face de l’autre. Nous pouvons communiquer le résultat en utilisant un code binaire : 0 pour pile, 1 pour pile. Il existe quatre messages possibles (00, 11, 01, 10) et chacun nécessite deux bits d’information.

Alors, quel est le point? Dans le premier scénario, vous aviez une certitude totale sur le contenu du message et il fallait zéro bit pour le transmettre. Dans la seconde, vous aviez 1 chance sur 4 de deviner la bonne réponse (25 % de certitude) et le message nécessitait deux informations pour résoudre cette ambiguïté. Plus généralement, moins vous en savez sur ce que le message va dire, plus il faut d’informations à transmettre.

Shannon a été la première personne à rendre cette relation mathématiquement précise. Il l’a capturé dans une formule qui calcule le nombre minimum de bits – un seuil appelé plus tard l’entropie de Shannon – requis pour communiquer un message. Il a également montré que si un expéditeur utilise moins de bits que le minimum, le message sera inévitablement déformé.

“Il avait cette grande intuition que l’information est maximisée lorsque vous êtes le plus surpris d’apprendre quelque chose”, a déclaré Tara Javidi, théoricienne de l’information à l’Université de Californie à San Diego.

Le terme « entropie » est emprunté à la physique, où l’entropie est une mesure du désordre. Un nuage a une entropie plus élevée qu’un glaçon, car un nuage permet beaucoup plus de façons d’arranger les molécules d’eau que la structure cristalline d’un cube. De manière analogue, un message aléatoire a une entropie de Shannon élevée – il y a tellement de possibilités pour organiser ses informations – alors qu’un message qui obéit à un modèle strict a une entropie faible. Il existe également des similitudes formelles dans la manière dont l’entropie est calculée à la fois en physique et en théorie de l’information. En physique, la formule de l’entropie consiste à prendre un logarithme d’états physiques possibles. En théorie de l’information, c’est le logarithme des résultats d’événements possibles.

La formule logarithmique de l’entropie de Shannon dément la simplicité de ce qu’elle capture, car une autre façon de penser à l’entropie de Shannon est le nombre de questions oui ou non nécessaires, en moyenne, pour déterminer le contenu d’un message.

Par exemple, imaginez deux stations météorologiques, l’une à San Diego, l’autre à Saint-Louis. Chacun veut envoyer les prévisions sur sept jours pour sa ville à l’autre. San Diego est presque toujours ensoleillé, ce qui signifie que vous avez une grande confiance dans ce que diront les prévisions. Le temps à Saint-Louis est plus incertain – la probabilité d’une journée ensoleillée est plus proche de 50-50.

Combien de questions oui ou non faudrait-il pour transmettre chaque prévision sur sept jours ? Pour San Diego, une première question intéressante pourrait être : les sept jours de prévision sont-ils ensoleillés ? Si la réponse est oui (et il y a de bonnes chances que ce soit le cas), vous avez déterminé l’ensemble des prévisions en une seule question. Mais avec Saint-Louis, vous devez presque parcourir les prévisions un jour à la fois : le premier jour est-il ensoleillé ? Qu’en est-il de la seconde ?

Plus il y a de certitude autour du contenu d’un message, moins vous aurez besoin de questions oui ou non, en moyenne, pour le déterminer.

Pour prendre un autre exemple, considérons deux versions d’un jeu d’alphabet. Dans le premier, j’ai choisi une lettre au hasard dans l’alphabet anglais et je veux que vous la deviniez. Si vous utilisez la meilleure stratégie de devinette possible, il vous faudra en moyenne 4,7 questions pour l’obtenir. (Une première question utile serait : « La lettre est-elle dans la première moitié de l’alphabet ? »)

Dans la deuxième version du jeu, au lieu de deviner la valeur de lettres aléatoires, vous essayez de deviner des lettres dans des mots anglais réels. Maintenant, vous pouvez personnaliser votre devinette pour tirer parti du fait que certaines lettres apparaissent plus souvent que d’autres (“Est-ce une voyelle ?”) et que connaître la valeur d’une lettre vous aide à deviner la valeur de la suivante (q est presque toujours suivi de u). Shannon a calculé que l’entropie de la langue anglaise est de 2,62 bits par lettre (ou 2,62 questions oui ou non), bien moins que les 4,7 dont vous auriez besoin si chaque lettre apparaissait au hasard. En d’autres termes, les modèles réduisent l’incertitude, ce qui permet de communiquer beaucoup en utilisant relativement peu d’informations.

Notez que dans des exemples comme ceux-ci, vous pouvez poser des questions meilleures ou pires. L’entropie de Shannon définit un plancher inviolable : c’est le nombre minimum absolu de bits, ou de questions par oui ou par non, nécessaires pour transmettre un message.

“Shannon a montré qu’il y a quelque chose comme la vitesse de la lumière, une limite fondamentale”, a déclaré Javidi. “Il a montré que l’entropie de Shannon est une limite fondamentale pour combien nous pouvons compresser une source, sans risquer de distorsion ou de perte.”

Aujourd’hui, l’entropie de Shannon sert de référence dans de nombreux contextes appliqués, y compris la technologie de compression de l’information. Le fait que vous puissiez compresser un fichier vidéo volumineux, par exemple, est dû au fait que les couleurs des pixels ont un modèle statistique, à la manière des mots anglais. Les ingénieurs peuvent créer des modèles probabilistes pour les modèles de couleurs de pixels d’une image à l’autre. Les modèles permettent de calculer l’entropie de Shannon en attribuant des poids aux motifs, puis en prenant le logarithme du poids pour toutes les façons possibles dont les pixels pourraient apparaître. Cette valeur vous indique la limite de compression “sans perte” – le maximum absolu que le film peut être compressé avant que vous ne commenciez à perdre des informations sur son contenu.

Les performances de tout algorithme de compression peuvent être comparées à cette limite. Si vous en êtes loin, vous êtes incité à travailler plus dur pour trouver un meilleur algorithme. Mais si vous en êtes proche, vous savez que les lois de l’information de l’univers vous empêchent de faire beaucoup mieux.

Image principale : pour communiquer une série d’événements aléatoires, tels que des tirages au sort, vous devez utiliser beaucoup d’informations, car il n’y a pas de structure dans le message. L’entropie de Shannon mesure cette contrainte fondamentale. Crédit : Kristina Armitage/Quanta Magazine.

Cet article a été initialement publié sur le Abstractions quantiques Blog.

-

Kévin Hartnett

Publié le 15 septembre 2022

Kevin Hartnett est rédacteur principal à Quanta Magazine couvrant les mathématiques et l’informatique. Son travail a été rassemblé dans la série “Best Writing on Mathematics” en 2013 et 2016. Il écrit également “Brainiac”, une chronique hebdomadaire pour le Globe de Bostonde la section Idées.

Recevoir la newsletter Nautilus

Les articles les plus récents et les plus populaires livrés directement dans votre boîte de réception !