De grands modèles de langage comme Lama 2 et ChatGPT c’est là qu’une grande partie de l’action se déroule dans l’IA. Mais dans quelle mesure les ordinateurs des centres de données actuels les exécutent-ils ? Assez bien, selon le dernier ensemble de résultats de référence pour l’apprentissage automatique, les meilleurs étant capables de résumer plus de 100 articles en une seconde. La livraison de données semestrielle de MLPerf a été publiée le 11 septembre et comprenait, pour la première fois, un test d’un grand modèle de langage (LLM), GPT-J. Quinze sociétés informatiques ont soumis des résultats de performances lors de ce premier essai LLM, s’ajoutant aux plus de 13 000 autres résultats soumis par un total de 26 sociétés. Dans l’un des faits marquants de la catégorie des centres de données, Nvidia a révélé les premiers résultats de référence pour son Grâce Hopper-un GPU H100 lié au nouveau processeur Grace de la société dans le même package comme s’il s’agissait d’une seule « superpuce ».

Parfois appelé « les Jeux olympiques de l’apprentissage automatique », MLPerf se compose de sept tests de référence : reconnaissance d’images, segmentation d’imagerie médicale, détection d’objets, reconnaissance vocale, traitement du langage naturel, un nouveau système de recommandation et maintenant un LLM. Cet ensemble de tests a testé l’efficacité d’un réseau neuronal déjà formé sur différents systèmes informatiques, un processus appelé inférence.

[For more details on how MLPerf works in general, go here.]

Le LLM, appelé GPT-J et publié en 2021, est plutôt petit pour de telles IA. Il est composé de quelque 6 milliards de paramètres, contre 175 milliards pour GPT-3. Mais c’était volontaire, selon MLCommons directeur exécutif David Kanter, parce que l’organisation souhaitait que cette référence soit réalisable par une grande partie de l’industrie informatique. Cela s’inscrit également dans la lignée d’un tendance vers des modèles plus compacts mais toujours des réseaux de neurones performants.

Il s’agissait de la version 3.1 du concours d’inférence, et comme lors des itérations précédentes, Nvidia dominait à la fois en nombre de machines utilisant ses puces et en performances. Cependant, Intel La Havane Gaudi2 a continué à mordiller le Nvidia H100les talons, et Cloud AI 100 de Qualcomm les puces ont fait de bons résultats dans les benchmarks axés sur la consommation d’énergie.

Nvidia toujours au top

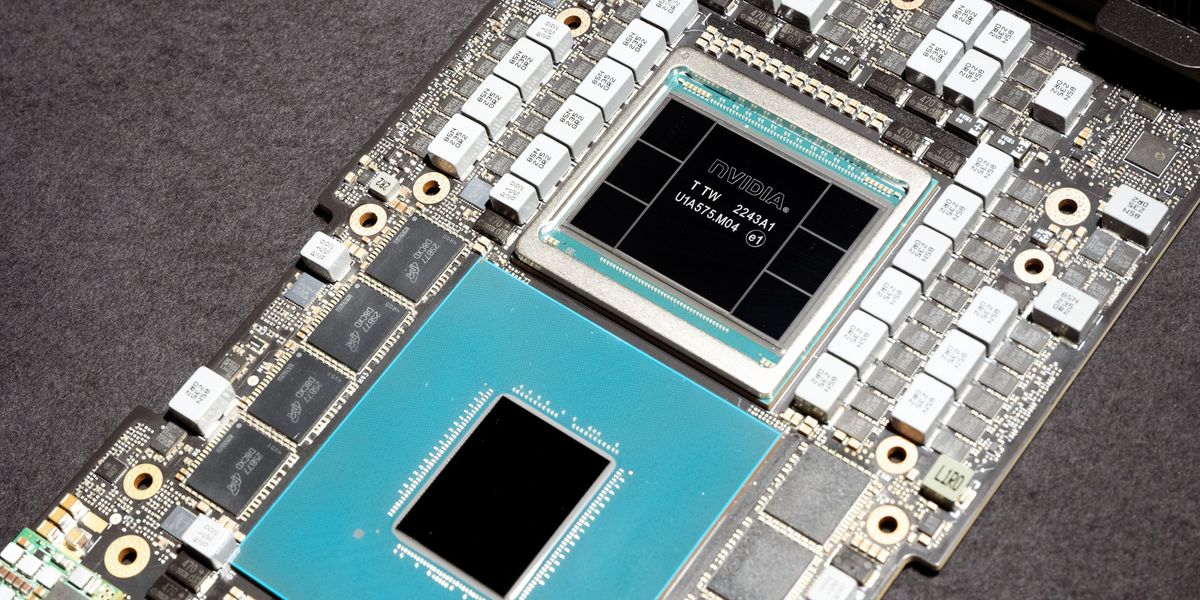

Cet ensemble de tests a vu l’arrivée de la superpuce Grace Hopper, un processeur Arm à 72 cœurs fusionné à un H100 via la liaison C2C propriétaire de Nvidia. La plupart des autres systèmes H100 s’appuient sur Intel Xéon ou AMD Épyc Processeurs hébergés dans un package séparé.

Le système comparable le plus proche du Grace Hopper était un ordinateur Nvidia DGX H100 combinant deux Intel Processeurs Xeon avec un GPU H100. La machine Grace Hopper a battu cela dans chaque catégorie de 2 à 14 pour cent, selon le benchmark. La plus grande différence a été obtenue dans le test du système de recommandation et la plus petite différence dans le test LLM.

Dave Salvatore, directeur de l’inférence, de l’analyse comparative et du cloud de l’IA chez Nvidia, a attribué une grande partie de l’avantage de Grace Hopper à l’accès à la mémoire. Grâce au lien propriétaire C2C qui relie la puce Grace à la puce Hopper, le GPU peut accéder directement à 480 Go de mémoire CPU, et 16 Go supplémentaires de mémoire à large bande passante sont connectés à la puce Grace elle-même. (La prochaine génération de Grace Hopper ajoutera encore plus de capacité de mémoire, passant de 96 Go à 140 Go aujourd’hui, dit Salvatore.) La puce combinée peut également diriger une puissance supplémentaire vers le GPU lorsque le CPU est moins occupé, permettant au GPU pour accroître ses performances.

Outre l’arrivée de Grace Hopper, Nvidia a eu sa belle performance habituelle, comme vous pouvez le voir dans les graphiques ci-dessous de tous les résultats de performances d’inférence pour les ordinateurs de classe centre de données.

Résultats de l’inférence du centre de données MLPerf v3.1

Nvidia est toujours celui à battre en matière d’inférence IA.

Nvidia

Les choses pourraient encore s’améliorer pour le géant des GPU. Nvidia a annoncé une nouvelle bibliothèque logicielle qui a effectivement doublé les performances du H100 sur GPT-J. Appelé TensorRT-LLM, il n’était pas prêt à temps pour les tests MLPerf v3.1, qui ont été soumis début août. L’innovation clé est ce qu’on appelle le traitement par lots en vol, explique Salvatore. Le travail impliqué dans l’exécution d’un LLM peut varier considérablement. Par exemple, on peut demander au même réseau neuronal de transformer un article de 20 pages en un essai d’une page ou de résumer un article d’une page en 100 mots. TensorRT-LLM empêche essentiellement ces requêtes de se bloquer les unes les autres, de sorte que les petites requêtes peuvent également être effectuées pendant que de gros travaux sont en cours.

Intel se rapproche

L’accélérateur Habana Gaudi2 d’Intel a traqué le H100 lors des précédentes séries de benchmarks. Cette fois, Intel n’a testé qu’un seul ordinateur à 2 processeurs et 8 accélérateurs et uniquement sur le benchmark LLM. Ce système était en retard de 8 à 22 % sur la machine la plus rapide de Nvidia dans cette tâche.

“En matière d’inférence, nous sommes presque à parité avec H100”, déclare Jordan Plawner, directeur principal des produits IA chez Intel. Les clients, dit-il, en viennent à considérer les puces Habana comme « la seule alternative viable au H100 », qui est en une demande extrêmement forte.

Il a également noté que Gaudi2 est une génération derrière le H100 en termes de technologie de fabrication de puces. La prochaine génération utilisera la même technologie de puce que le H100, dit-il.

Intel a également utilisé historiquement MLPerf pour montrer tout ce qui peut être fait en utilisant uniquement les processeurs, bien que les processeurs soient désormais dotés d’une unité de calcul matricielle dédiée pour faciliter les réseaux neuronaux. Ce tour n’était pas différent. Six systèmes de deux processeurs Intel Xeon chacun ont été testés sur le benchmark LLM. Même s’ils étaient loin d’être conformes aux normes GPU (le système Grace Hopper était souvent 10 fois plus rapide que n’importe lequel d’entre eux, voire plus rapide), ils pouvaient quand même cracher un résumé toutes les secondes environ.

Résultats d’efficacité du centre de données

Seules les puces Qualcomm et Nvidia ont été mesurées pour cette catégorie. Qualcomm a déjà souligné l’efficacité énergétique de ses accélérateurs, mais les machines Nvidia H100 ont également bien rivalisé.

À partir des articles de votre site

Articles connexes sur le Web