Le clip représente un événement historique réel : un discours prononcé par le dictateur nazi Adolf Hitler en 1939 au début de la Seconde Guerre mondiale.

Mais il y a une différence majeure. Cette vidéo virale a été modifiée par l’intelligence artificielle, dans laquelle Hitler tient des propos antisémites en anglais.

Un influenceur conspirationniste d’extrême droite a partagé le contenu sur X, anciennement connu sous le nom de Twitter, plus tôt cette année, et il a rapidement accumulé plus de 15 millions de vues, a rapporté le magazine Wired en mars.

Ce n’est qu’un exemple de ce que les chercheurs et les organisations qui surveillent les contenus haineux qualifient de tendance inquiétante.

Ils affirment que la haine générée par l’IA est en hausse.

“Je pense que tous ceux qui font des recherches sur les contenus haineux ou les médias haineux voient de plus en plus de contenus générés par l’IA”, a déclaré Peter Smith, journaliste qui travaille pour le Réseau canadien anti-haine.

Chris Tenove, directeur adjoint du Centre d’étude des institutions démocratiques de l’Université de la Colombie-Britannique, a déclaré que les groupes haineux, tels que les groupes suprémacistes blancs, « ont été historiquement les premiers à adopter les nouvelles technologies et techniques Internet ».

C’est une préoccupation signalée par un organisme consultatif de l’ONU en décembre. Il s’est déclaré “profondément préoccupé” par la possibilité que des contenus antisémites, islamophobes, racistes et xénophobes “soient suralimentés par l’IA générative”.

Parfois, ce contenu peut se répercuter sur la vie réelle.

Après que l’IA ait été utilisée pour générer ce que Smith a décrit comme des « affiches de films extrêmement racistes de style Pixar », certaines personnes ont imprimé les panneaux et les ont affichés sur le côté des salles de cinéma, a-t-il déclaré.

“Tout ce qui est accessible au public, qui est populaire ou émergent, notamment en matière de technologie, est très vite adapté pour produire de la propagande haineuse.”

Les systèmes d’IA générative peuvent créer des images et des vidéos presque instantanément avec une simple invite.

Au lieu qu’un individu consacre des heures à créer une seule image, il peut en créer des dizaines “dans le même laps de temps, en quelques frappes seulement”, a déclaré Smith.

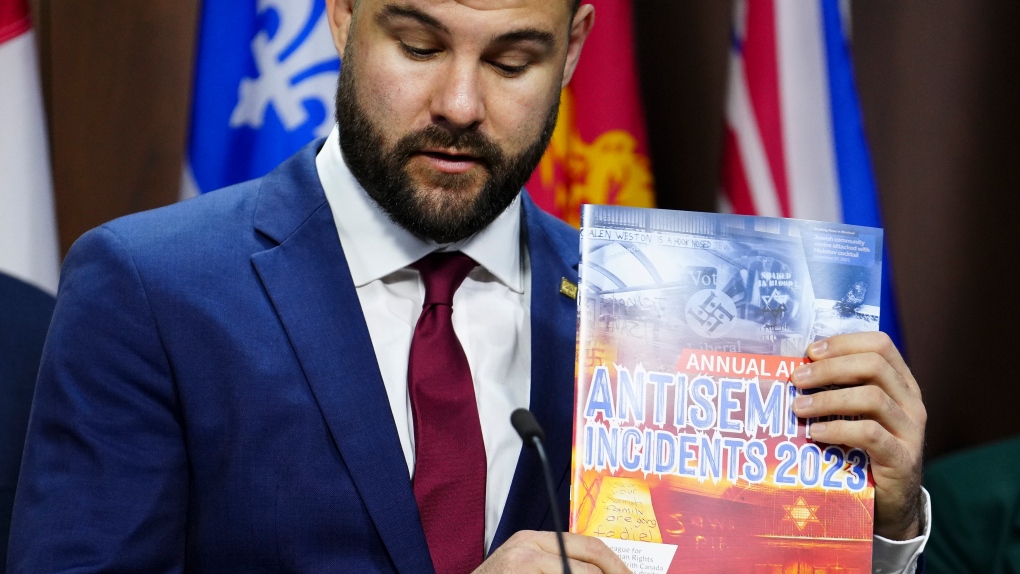

B’nai Brith Canada a signalé la question du contenu haineux généré par l’IA dans un récent rapport sur l’antisémitisme.

Le rapport indique que l’année dernière a vu une « augmentation sans précédent des images et vidéos antisémites créées ou falsifiées à l’aide de l’IA ».

Le directeur de la recherche et du plaidoyer, Richard Robertson, a déclaré que le groupe avait observé que « des images vraiment horribles et graphiques, généralement liées au négationnisme, à la diminution ou à la distorsion de l’Holocauste, étaient produites à l’aide de l’IA ».

Il a cité l’exemple d’une image falsifiée représentant un camp de concentration avec un parc d’attractions à l’intérieur.

“Les victimes de l’Holocauste montent à bord des manèges, semblant s’amuser dans un camp de concentration nazi, et c’est sans doute quelque chose qui ne peut être produit qu’en utilisant l’IA”, a-t-il déclaré.

Le rapport de l’organisation indique également que l’IA a « eu un impact considérable » sur la propagation de la propagande à la suite de la guerre entre Israël et le Hamas.

L’IA peut être utilisée pour créer des deepfakes ou des vidéos présentant des simulations remarquablement réalistes de célébrités, d’hommes politiques ou d’autres personnalités publiques.

Tenove a déclaré que les deepfakes dans le contexte de la guerre entre Israël et le Hamas ont provoqué la diffusion de fausses informations sur les événements et ont attribué de fausses déclarations à la fois à l’armée israélienne et aux responsables du Hamas.

“Il y a donc eu ce genre de choses, qui consistent à essayer d’attiser la colère ou la peur des gens à l’égard de l’autre côté et à utiliser la tromperie pour y parvenir.”

Jimmy Lin, professeur à l’école d’informatique de l’Université de Waterloo, reconnaît qu’il y a eu « une légère hausse du nombre de faux contenus… spécialement conçus pour agacer les gens des deux côtés ».

Amira Elghawaby, représentante spéciale du Canada pour la lutte contre l’islamophobie, affirme qu’il y a eu une augmentation des récits antisémites et islamophobes depuis le début du conflit.

Elle dit que la question de l’IA et des contenus haineux mérite à la fois davantage d’études et de discussions.

Il ne fait aucun doute que le contenu haineux généré par l’IA est un problème émergent, mais les experts ne sont pas encore parvenus à un consensus sur l’ampleur du problème.

Tenove a déclaré qu’il y avait “beaucoup de conjectures en ce moment”, semblables à des questions sociétales plus larges sur “les contenus nuisibles ou problématiques qui se propagent sur les plateformes de médias sociaux”.

Des systèmes comme ChatGPT intègrent des protections, a déclaré Lin. Un porte-parole d’OpenAI a confirmé qu’avant de lancer un nouveau système, l’entreprise apprend au modèle à refuser de générer des discours de haine.

Mais Lin a déclaré qu’il existe des moyens de jailbreaker les systèmes d’IA, notant que certaines invites peuvent « tromper le modèle » pour qu’il produise ce qu’il a décrit comme un contenu désagréable.

David Evan Harris, chercheur à l’Université de Californie à Berkeley, a déclaré qu’il était difficile de savoir d’où vient le contenu de l’IA à moins que les entreprises à l’origine de ces modèles ne veillent à ce qu’il soit filigrané.

Il a déclaré que certains modèles d’IA, comme ceux créés par OpenAI ou Google, sont des modèles à source fermée. D’autres, comme Meta’s Llama, sont rendus plus ouvertement disponibles.

Une fois qu’un système est ouvert à tous, il a déclaré que les mauvais acteurs peuvent supprimer les dispositifs de sécurité et produire des discours de haine, des escroqueries et des messages de phishing d’une manière très difficile à détecter.

Une déclaration de Meta indique que la société intègre des mesures de protection dans ses systèmes et n’ouvre pas “tout” en open source.

“Les logiciels open source sont généralement plus sûrs et sécurisés grâce aux commentaires, à l’examen, au développement et aux mesures d’atténuation continus de la part de la communauté”, indique-t-il.

Au Canada, il existe une loi fédérale qui, selon le gouvernement libéral, contribuera à résoudre le problème. Cela inclut le projet de loi C-63, un projet de loi proposé pour lutter contre les méfaits en ligne.

Chantalle Aubertin, porte-parole du ministre de la Justice Arif Virani, a déclaré que la définition du contenu qui fomente la haine dans le projet de loi inclut « tout type de contenu, comme les images et les vidéos, et tout contenu généré artificiellement, comme les deepfakes ».

Innovation Canada a déclaré que sa proposition de loi sur la réglementation de l’intelligence artificielle, le projet de loi C-27, exigerait que le contenu de l’IA soit identifiable, par exemple grâce au filigrane.

Un porte-parole a déclaré que le projet de loi “exigerait également que les entreprises responsables de systèmes d’IA à fort impact et à usage général évaluent les risques, testent et surveillent leurs systèmes pour s’assurer qu’ils fonctionnent comme prévu, et mettent en place des mesures d’atténuation appropriées pour faire face à tout risque”. du mal.”

Ce rapport de La Presse Canadienne a été publié pour la première fois le 26 mai 2024.

:quality(70)/cloudfront-us-east-1.images.arcpublishing.com/cmg/IKKSYL74UZEUZGJFJB6LIIX5B4.jpg)