La famille comprend trois modèles d’IA de pointe par ordre croissant de capacités : Claude 3 Haiku, Claude 3 Sonnet et Claude 3 Opus. La société affirme que chaque modèle offre des performances de plus en plus puissantes, offrant un équilibre entre intelligence, vitesse et coût en fonction de leur cas d’utilisation spécifique.

Anthropic a été fondée par d’anciens membres d’OpenAI, la société derrière ChatGPT. Sa co-fondatrice et présidente Daniela Amodei a déclaré dans une interview avec Bloomberg Technology que les nouveaux modèles sont deux fois plus susceptibles de répondre correctement aux questions. Cela fait référence à la fréquence à laquelle les modèles génèrent des informations incorrectes comme réponses, comme c’est le cas avec des chatbots IA similaires.

De plus, elle a déclaré qu’Anthropic travaillait sur les défis auxquels les entreprises sont confrontées lors de l’intégration de l’IA dans leurs flux de travail.

Qu’est-ce que Claude 3 ?

Claude est un groupe de grands modèles de langage (LLM) développés par Anthropic. Le chatbot est capable de gérer du texte, des messages vocaux et des documents. Commentaires par L’Express indien ont montré que le chatbot est capable de générer des réponses contextuelles plus rapides que ses pairs.

Parmi les nouveautés, Claude 3 Opus est le modèle le plus puissant, Claude 3 Sonnet est le modèle intermédiaire, performant et à prix compétitif, et Claude 3 Haiku est pertinent pour tout cas d’utilisation nécessitant des réponses instantanées.

Claude Sonnet alimente actuellement gratuitement le chatbot Claude.ai et les utilisateurs n’ont besoin que d’une connexion par e-mail. Cependant, Opus n’est disponible que via l’interface de chat Web d’Anthropic et si un utilisateur est abonné au service Claude Pro sur le site Anthropic. Il est disponible pour 20 $ par mois.

Tous les nouveaux modèles sont dotés d’une fenêtre de 2 00 000 jetons, ce qui signifie éventuellement de meilleures performances, précision et capacité à saisir plus d’informations dans une invite utilisateur.

Comment s’est comporté Claude 3 ?

D’après la comparaison de Claude 3 avec ses pairs, il semble qu’Anthropic ait rattrapé son retard sur OpenAI. Il avait dépassé de nombreux modèles d’IA avec le lancement de son GPT-4 Turbo.

Cependant, cette analyse est uniquement basée sur les scores de référence qu’Anthropic a partagés dans son annonce. Plusieurs experts ont suggéré que la présentation des références en matière d’IA serait très probablement sélectionnée par les créateurs.

Claude 3 aurait démontré des performances avancées dans des tâches cognitives telles que le raisonnement, les connaissances expertes, les mathématiques et la maîtrise de la langue. Malgré l’absence de consensus sur la question de savoir si les LLM peuvent réellement « savoir » ou « raisonner », la communauté de recherche en IA utilise couramment ces termes.

La société affirme que le modèle Opus présente « des niveaux de compréhension et de maîtrise quasi humains sur des tâches complexes ».

Bien qu’il s’agisse d’une affirmation importante, les scores montrent que Claude 3 Opus a montré des performances quasi humaines sur des critères spécifiques. Cependant, cela ne signifie pas qu’Opus possède une intelligence générale comme les humains.

Claude 3 contre GPT-4

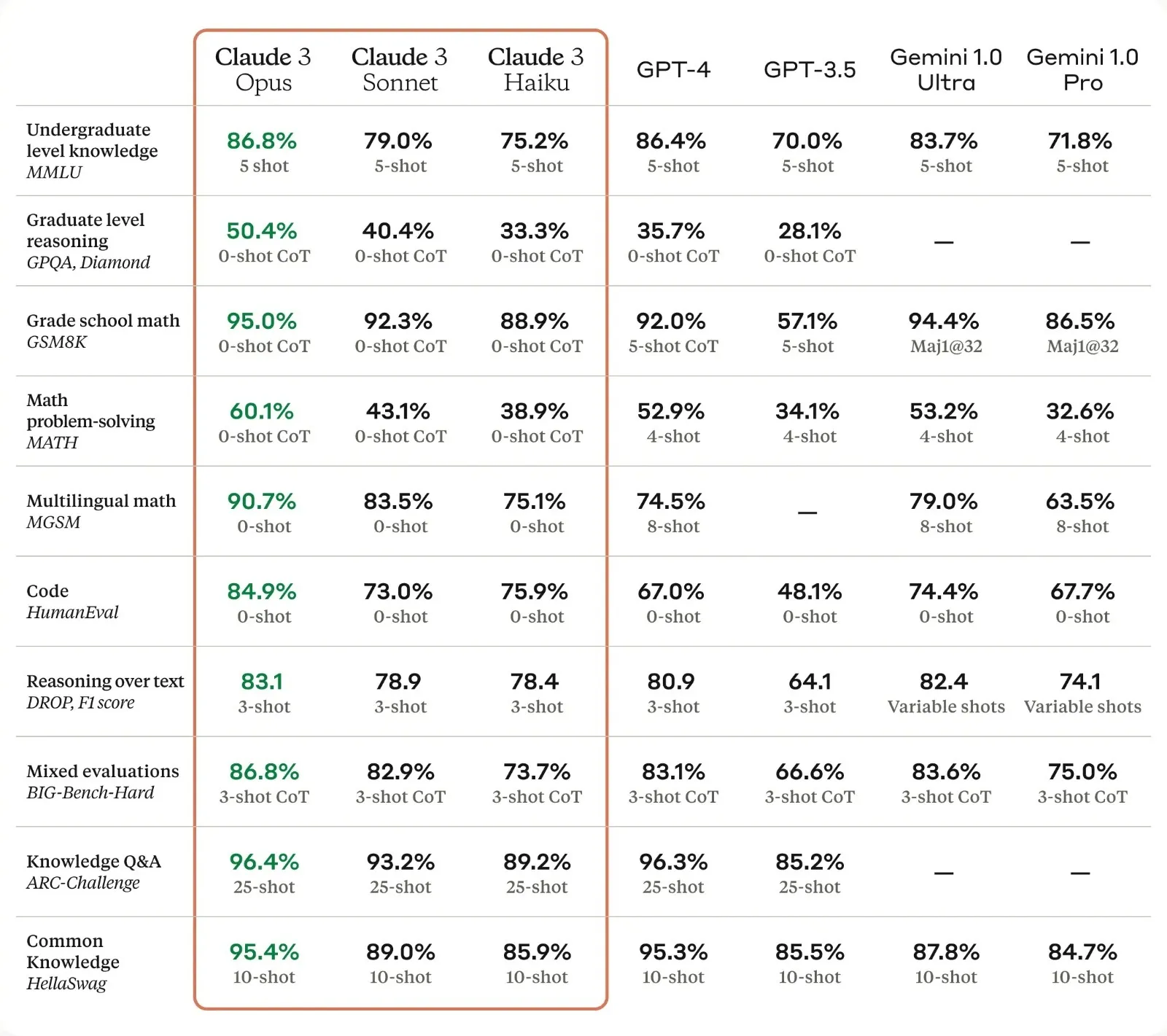

Claude 3 Opus a surpassé GPT-4 sur pas moins de 10 tests d’IA, dont MMLU (connaissances de premier cycle), HumanEval (codage), HellaSwag (connaissances communes) et GSM8K (mathématiques à l’école primaire).

Sur les scores de référence, Claude 3 bat ses pairs de peu. Par exemple, dans l’essai MMLU à cinq coups, Claude 3 a obtenu 86,8 pour cent tandis que GPT-4 a obtenu 86,4 pour cent.

Scores de référence. (Source de l’image : Anthropique)

Scores de référence. (Source de l’image : Anthropique)

D’un autre côté, des écarts importants peuvent également être observés, comme en mathématiques multilingues (MGSM), Claude 3 a obtenu un score de 90,7 pour cent, tandis que GPT-4 a clôturé à 74,5 pour cent.

Même si ces scores semblent excellents sur le papier, il est difficile de prédire comment ils se traduisent pour les utilisateurs. De plus, les experts affirment que les benchmarks LLM doivent être traités avec prudence. Même si l’on ne peut pas évaluer leur facilité d’utilisation, les scores en eux-mêmes sont significatifs car ils dépassent GPT-4.

Claude 3 a également montré des améliorations en termes d’analyse, de prévision, de création de contenu, de conversations multilingues, de génération de code, etc. Anthropic a affirmé que la nouvelle famille de modèles est également dotée de capacités de vision améliorées, permettant à Claude 3 de traiter des photos, des graphiques et des diagrammes. un peu comme GPT-4V.

Limites de Claude 3

Selon ceux qui ont eu un accès précoce au modèle, Claude 3 réussit bien dans des tâches telles que répondre à des questions factuelles et à la reconnaissance optique de caractères (OCR), c’est-à-dire la capacité d’extraire du texte à partir d’images. Apparemment, le nouveau modèle est capable de suivre des instructions et d’accomplir des tâches telles que l’écriture de sonnets shakespeariens.

Cependant, il se heurte parfois à des raisonnements complexes et à des problèmes mathématiques. Ses réponses ont également fait preuve de préjugés, par exemple en favorisant un certain groupe racial par rapport à d’autres.

Dans le passé également, d’autres modèles d’IA ont été confrontés à des problèmes similaires. Le chatbot IA Gemini de Google a été critiqué après avoir montré des préjugés raciaux et des inexactitudes historiques. Il refusait de générer des images d’individus blancs et décrivait ces individus comme des personnes de couleur.

Anthropic a souligné les caractéristiques de sécurité de Claude 3, notamment son refus de générer du contenu préjudiciable ou illégal.

L’entreprise a également été parmi les premières à mettre en place l’IA constitutionnelle. Les développeurs ont établi un ensemble de valeurs que le système doit suivre pour qu’il entreprenne des actions politiquement et socialement responsables.

Pour l’instant, le Claude 3 est le modèle le plus cher du marché, mais Anthropic prévoit de sortir prochainement des versions abordables. Sur la base des premiers rapports, des benchmarks et de la confiance de la communauté de l’IA, Claude 3 semble être une avancée significative dans le développement des LLM.