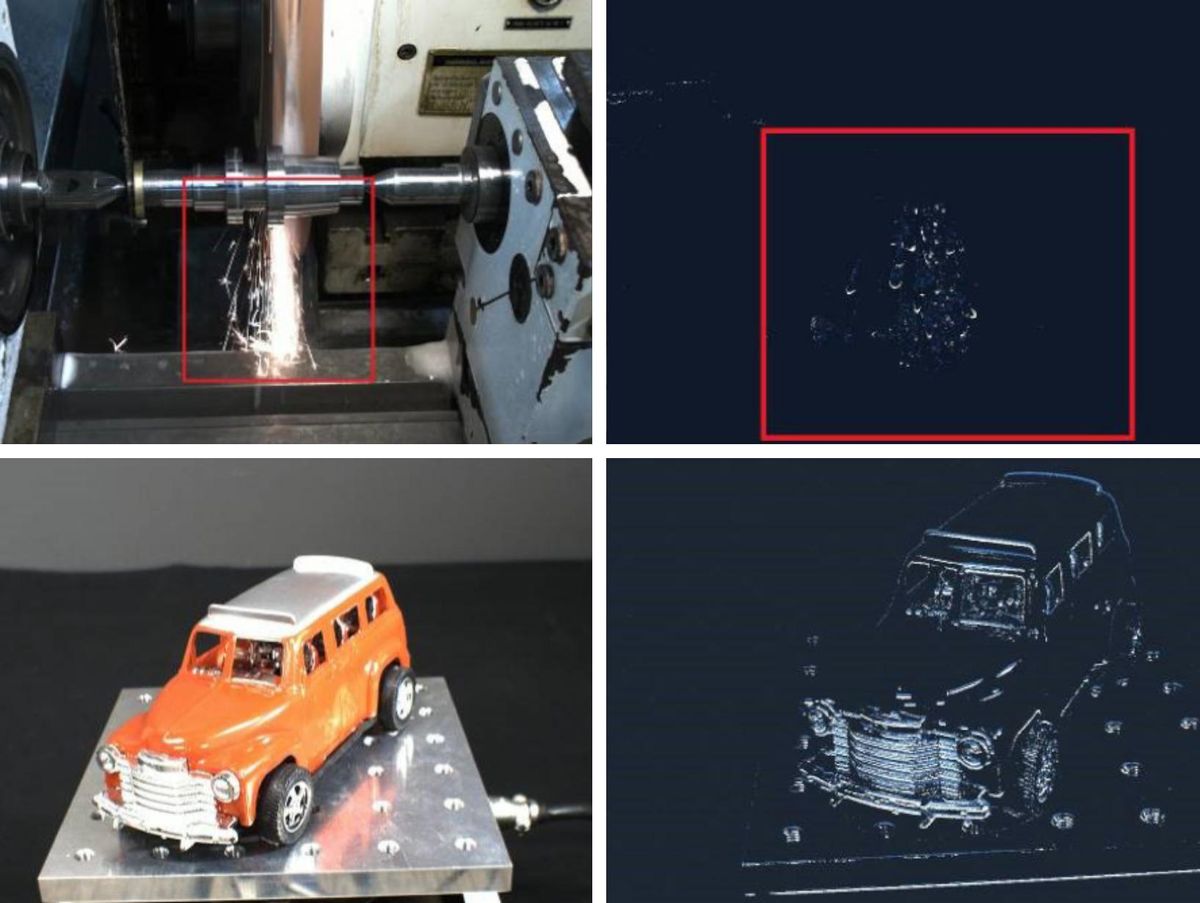

Ce mois-ci, Sony commence à livrer ses premières puces de caméra événementielles haute résolution. Les caméras ordinaires capturent des scènes complètes à intervalles réguliers même si la plupart des pixels de ces images ne changent pas d’une scène à l’autre. Les pixels des caméras événementielles – une technologie inspirée des systèmes de vision animale – ne réagissent que s’ils détectent un changement dans la quantité de lumière qui leur tombe dessus. Par conséquent, ils consomment peu d’énergie et génèrent beaucoup moins de données tout en capturant particulièrement bien les mouvements. Les deux puces Sony, l’IMX636 de 0,92 mégapixel et la plus petite IMX637 de 0,33 mégapixel, combinent les circuits basés sur les événements de Prophesee avec la technologie d’empilement de puces 3D de Sony pour produire une puce avec les pixels basés sur les événements les plus petits du marché. Le PDG de Prophesee, Luca Verre, explique ce qui va suivre pour cette technologie neuromorphique.

Luca Verre on…

Le rôle des capteurs événementiels dans les voitures

Avancées dans les futures puces

La longue route vers ce jalon

Spectre IEEE : En annonçant les IMX636 et 637, Sony a mis en avant les applications de vision industrielle pour celui-ci. Mais lorsque nous avons parlé l’année dernière, la réalité augmentée et les applications automobiles semblaient être une priorité.

Luca Verre, PDG et cofondateur de Prophesee

Luca Verre : Le champ d’application est plus large qu’industriel. Dans le domaine de l’automobile, nous sommes en effet très actifs dans les applications non liées à la sécurité. En avril, nous avons annoncé un partenariat avec Xperi, qui a développé une solution de surveillance du conducteur en cabine pour la conduite autonome. [Car makers want in-cabin monitoring of the driver to ensure they are attending to driving even when a car is autonomous mode.] Applications liées à la sécurité [such as sensors for autonomous driving] n’entre pas dans le champ d’application de l’IMX636 car il nécessiterait une conformité de sécurité, ce à quoi cette conception n’est pas destinée. Cependant, il existe un certain nombre de fournisseurs OEM et de niveau 1 qui en font une évaluation, pleinement conscients que le capteur ne peut pas être mis en production en série tel quel. Ils le testent parce qu’ils veulent évaluer les performances de la technologie, puis envisagent potentiellement de nous pousser, ainsi que Sony, à le reconcevoir, pour le rendre conforme à la sécurité. La sécurité automobile reste un domaine d’intérêt, mais à plus long terme. Dans tous les cas, si certains de ces travaux d’évaluation aboutissaient à une décision de développement de produit, cela prendrait pas mal d’années [before it appears in a car].

Retour au sommet

Spectre IEEE : Quelle est la prochaine étape pour ce capteur ?

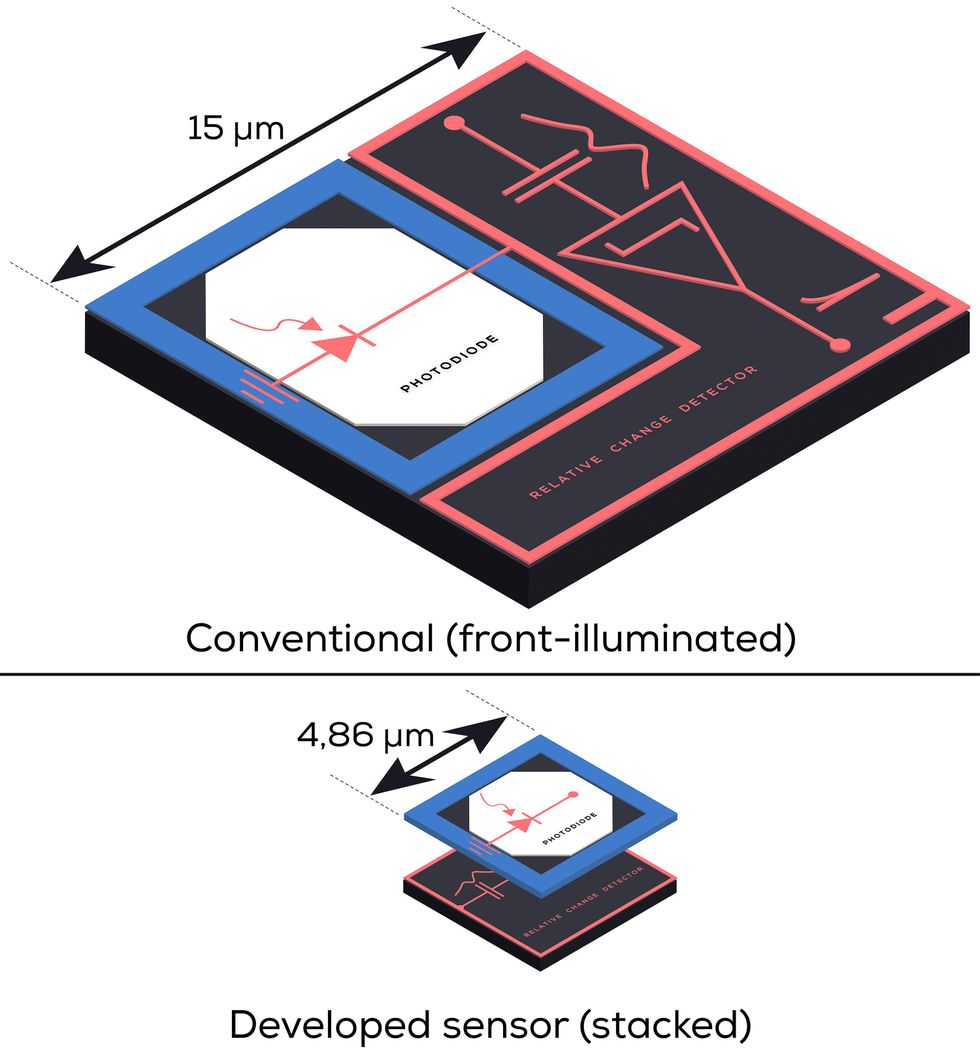

Luca Verre : Pour la prochaine génération, nous travaillons selon trois axes. Un axe est autour de la réduction du pas de pixel. Avec Sony, nous avons fait de grands progrès en réduisant le pas de pixel des 15 micromètres de la génération 3 à 4,86 micromètres avec la génération 4. Mais, bien sûr, il reste encore beaucoup à faire en utilisant un nœud technologique plus avancé ou en en utilisant la technologie d’empilage maintenant arrivée à échéance des piles doubles et triples. [The sensor is a photodiode chip stacked onto a CMOS chip.] Vous avez le processus de photodiode, qui fait 90 nanomètres, puis la partie intelligente, la partie CMOS, a été développée sur 40 nanomètres, ce qui n’est pas nécessairement un nœud très agressif. En optant pour des nœuds plus agressifs comme 28 ou 22 nm, le pas de pixel se rétrécira beaucoup.

Conception de pixels conventionnels ou empilésprophétiser

Conception de pixels conventionnels ou empilésprophétiser

Les avantages sont clairs : c’est un avantage en termes de coût ; c’est un avantage en termes de réduction du format optique du module caméra, ce qui signifie également une réduction des coûts au niveau du système ; De plus, il permet l’intégration dans des appareils qui nécessitent des contraintes d’espace plus serrées. Et puis bien sûr, l’autre avantage lié est le fait qu’avec une surface de silicium équivalente, on peut mettre plus de pixels, donc la résolution augmente. La technologie événementielle ne suit pas forcément la même course que l’on voit encore dans le conventionnel [color camera chips]; nous ne filmons pas pour des dizaines de millions de pixels. Ce n’est pas nécessaire pour la vision industrielle, à moins que vous ne considériez certaines applications exotiques très spécialisées.

Le deuxième axe concerne la poursuite de l’intégration de la capacité de traitement. Il est possible d’intégrer davantage de capacités de traitement à l’intérieur du capteur pour le rendre encore plus intelligent qu’il ne l’est aujourd’hui. Aujourd’hui, c’est un capteur intelligent dans le sens où il traite les changements [in a scene]. Il s’agit également de formater ces modifications pour les rendre plus compatibles avec les [system-on-chip] Plate-forme. Mais vous pouvez même pousser ce raisonnement plus loin et penser à faire une partie du traitement local à l’intérieur du capteur [that’s now done in the SoC processor].

Le troisième est lié à la consommation électrique. Le capteur, par conception, est en fait de faible puissance, mais si l’on veut atteindre un niveau extrême de faible puissance, il y a encore moyen de l’optimiser. Si vous regardez l’IMX636 gen 4, la puissance n’est pas forcément optimisée. En fait, ce qui est optimisé davantage, c’est le débit. C’est la capacité de réagir réellement à de nombreux changements dans la scène et de pouvoir les horodater correctement avec une précision temporelle extrêmement élevée. Ainsi, dans des situations extrêmes où les scènes changent beaucoup, le capteur a une consommation électrique équivalente à un capteur d’image conventionnel, bien que la précision temporelle soit beaucoup plus élevée. Vous pouvez affirmer que dans ces situations, vous exécutez l’équivalent de 1000 images par seconde ou même au-delà. Il est donc normal que vous consommiez autant qu’un capteur de 10 ou 100 images par seconde.[A lower power] Le capteur pourrait être très attrayant, en particulier pour les appareils grand public ou les appareils portables pour lesquels nous savons qu’il existe des fonctionnalités liées au suivi oculaire, à la surveillance de l’attention, au verrouillage des yeux, qui deviennent très pertinentes.

Retour au sommet

Spectre IEEE : La réduction de la puissance est-elle simplement une question d’utilisation d’un nœud de technologie de semi-conducteurs plus avancé ?

Luca Verre : L’utilisation d’une technologie plus agressive aidera certainement, mais je pense que de manière marginale. Ce qui aidera considérablement, c’est d’avoir un programme de mode réveil dans le capteur. Par exemple, vous pouvez avoir un tableau dans lequel essentiellement quelques pixels actifs sont toujours activés. Les autres sont complètement fermés. Et puis quand on a atteint une certaine masse critique d’événements, on réveille tout le reste.

Spectre IEEE : Comment s’est passé le parcours du concept au produit commercial ?

Luca Verre : Pour moi, cela a été un voyage de sept ans. Pour mon co-fondateur, le CTO Christoph Posch, cela a été encore plus long car il a commencé la recherche en 2004. Pour être honnête avec vous, quand j’ai commencé, je pensais que le temps de mise sur le marché aurait été plus court. Et avec le temps, je me suis rendu compte que [the journey] était beaucoup plus complexe, pour différentes raisons. La première et la plus importante des raisons était l’absence d’écosystème. Nous sommes les pionniers, mais être les pionniers a aussi quelques inconvénients. Vous êtes seul devant tout le monde et vous devez amener des amis avec vous, car en tant que fournisseur de technologie, vous ne fournissez qu’une partie de la solution. Lorsque j’ai présenté l’histoire de Prophesee au tout début, c’était l’histoire d’un capteur aux avantages énormes. Et je pensais, naïvement pour être honnête, que les avantages étaient si évidents et simples que tout le monde sauterait dessus. Mais en réalité, même si tout le monde était intéressé, ils voyaient aussi le défi de l’intégrer : construire un algorithme, mettre le capteur à l’intérieur du module caméra, s’interfacer avec un système sur puce, construire une application. Ce que nous avons fait avec Prophesee au fil du temps était de travailler davantage au niveau du système. Bien sûr, nous avons continué à développer le capteur, mais nous avons également développé de plus en plus d’actifs logiciels.

À l’heure actuelle, plus de 1 500 utilisateurs uniques expérimentent notre logiciel. De plus, nous avons mis en place une caméra d’évaluation et un kit de développement, en connectant notre capteur à une plate-forme SoC. Aujourd’hui, nous sommes en mesure de donner à l’écosystème non seulement le capteur, mais bien plus que cela. Nous pouvons leur donner des outils qui peuvent leur permettre de rendre les avantages clairs. La deuxième partie est plus fondamentale pour la technologie. Lorsque nous avons commencé il y a sept ans, nous avions une puce énorme ; c’était un pas de pixel de 30 micromètres. Et bien sûr, nous savions que le chemin pour entrer dans les applications à grand volume était très long, et nous devions trouver ce chemin en utilisant une technologie empilée. Et c’est la raison pour laquelle, il y a quatre ans, nous avons convaincu Sony de travailler ensemble. À l’époque, la première technologie d’empilage 3D à rétroéclairage était disponible, mais elle n’était pas vraiment accessible. [In backside illumination, light travels through the back of the silicon to reach photosensors on the front.

Sony’s 3D stacking technology moves the logic that reads and controls the pixels to a separate silicon chip, allowing pixels to be more densely packed.] Les deux plus grandes sociétés de capteurs d’images, Sony et Samsung, ont leur propre processus en interne. [Others’ technologies] ne sont pas aussi avancés que les deux leaders du marché. Mais nous avons réussi à développer une relation avec Sony, à accéder à leur technologie et à fabriquer le premier capteur basé sur les événements de pile 3D à éclairage arrière de qualité industrielle, disponible dans le commerce, dont la taille est compatible avec les appareils grand public. Nous savions depuis le début que cela aurait dû faire, mais le chemin pour atteindre le point n’était pas nécessairement clair. Sony ne le fait pas très souvent. L’IMX636 est le seul [sensor] que Sony a co-développé avec un partenaire externe. C’est, pour moi, un motif de fierté, car je pense qu’ils ont cru en nous, en notre technologie et en notre équipe.

Retour au sommet

.